Deepfake’ler hatırladıklarımızı nasıl değiştiriyor

İnternet, son zamanlarda kafa karıştırıcı görüntülerle çalkalandı. Şişkin bir mont giyen papa ve diz çöker halde Xi Jinping’in elini öpen Vladimir Putin. Peki görüntülerdeki problem ne? Aslında hiç gerçekleşmemiş olmaları. Bu görüntüler, deepfake olarak bilinen gelişmiş yapay zeka teknolojisinin birer ürünü.

Bu derin öğrenme temelli sahte görüntüler, yapay zekanın gerçek ile kurgu arasındaki sınırları nasıl kolayca ortadan kaldırabileceğini ve bunun önemli ve sınırları aşan sonuçları olabileceğini gösteriyor.

[Taahhütsüz VPN denemesi ile çevrimiçi aktivitenizi koruyun ve kişisel bilgilerinizi gizli tutun.]

Yapay zekanın hatırladıklarımızı nasıl değiştirdiğini ve deepfake’lerin Mandela Etkisi olarak bilinen olguya potansiyel katkısını inceliyoruz. Bildiğinizi sandığınız her şeyi sorgulamaya hazır olun.

Mandela etkisi nedir?

Bu terim, adını Güney Afrikalı anti-apartheid (ırk ayrımcılığı karşıtı) devrimci ve politikacı Nelson Mandela’dan almıştır. Çoğu insan, aksini gösteren birçok kanıt bulunmasına rağmen, Mandela’nın 1980’lerde cezaevinde öldüğüne inandı. Gerçekte ise; Mandela 1990 yılında serbest bırakıldı, Güney Afrika’nın devlet başkanı oldu ve 2013 yılında hayatını kaybetti.

Mandela etkisi o zamandan beri marka adlarının yazılışı, şarkı sözleri, filmlerin veya dizilerin hikayesi ve tarihsel olayların detayları gibi birçok yanlış hatırlanan olayları veya ayrıntıları tanımlamak için kullanıldı.

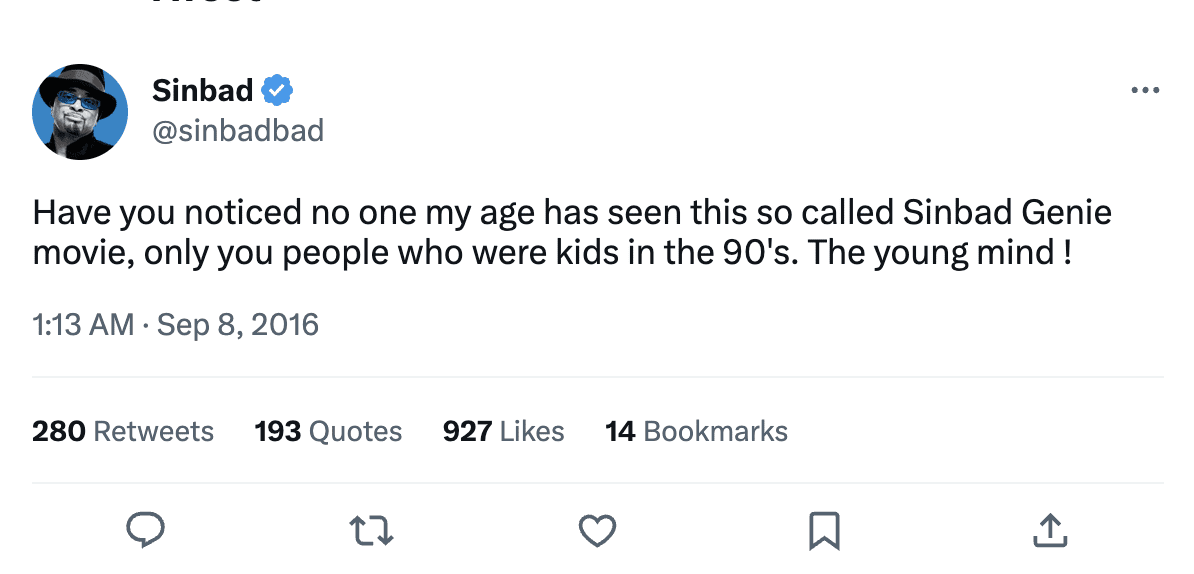

Mandela etkisinin gerçekteki örneklerinden biri, 1990’ların popüler komedyeni Sinbad’ı içeriyor. Birçok insan, Shazaam (2019’daki süper kahraman filmi Shazam! ile karıştırılmasın) adlı bir filmi hatırladıklarını ve Sinbad’ın bu filmde iki çocuğa yardım eden bir cin rolünde oynadığını iddia ediyor. Ancak böyle bir film hiç çekilmedi. Buna en yakın şey Kazaam adlı bir film ve bu filmde Shaquille O’Neal bir cini canlandırıyor.

Shazaam’ın var olduğuna dair kanıtların olmamasına rağmen, çoğu insan bu filmi izlediklerinden ve hikayesinin detaylarını, karakterleri ve hatta film afişini hatırladıklarından çok eminler. Sinbad katiyen bir cin rolünde oynamadığını teyit etmesine rağmen, filmin sanısı insanların zihinlerine o derece işlemiş ki bu filmin varlığından hiç kuşku duymuyorlar.

[evpn_typeform id="nKNZXuKs"]

Mandela etkisine yol açan şey nedir?

Her ne kadar Mandela etkisinin sebebi tamamen anlaşılmasa da bunu açıklamaya çalışan birçok teori bulunuyor. Bu teorilerden biri, insanların bazı olayları veya gerçekleri yanlış bilgilendirilme, yanlış yorumlama veya iddianın gücü nedeniyle yanlış hatırladığı sahte hatıraların bir sonucu olduğunu öneriyor. Başka bir uçuk teori ise, bunun matrix veya paralel evrendeki bir kusurdan dolayı insanların gerçeğin farklı bir versiyonunu deneyimlemesi nedeniyle oluştuğunu iddia ediyor.

Psikologlar, Mandela etkisinin beynimizin yapısından kaynaklandığını düşünüyor. Spesifik olarak, bunu zihnimizin bazen diğer insanların söylediği şeylerden veya bazı şeyleri yanlış hatırlamamıza neden olan kendi mevcut inançlarımızdan etkilenmesinden dolayı düşünüyorlar. Bu durum, bilişsel önyargı olarak adlandırılıyor. Örneğin, sosyal medyada birçok insan bir şeyin belirli bir şekilde gerçekleştiğini söylerse, o şey o şekilde gerçekleşmemiş olsa bile, gerçekten de o şekilde gerçekleştiğine inanmamızı sağlayabilir.

Mandela etkisinin yeni bir olgu olmamasına ve çoğunlukla popüler kültürle alakalı olmasına rağmen, deepfake’lerin artışı, yanlış bilgilerin çok daha hızlı ve kolay bir şekilde yayılabileceği ve daha çok insanın hiç olmayan şeyleri olmuş gibi hatırlamaya başlayabilecekleri anlamına geliyor.

Bu durum; internette gördüğümüz bilgilere inanıp inanmama, fotoğrafları ve videoları yapay zeka kullanarak değiştirmenin etik olup olmadığı ve teknolojinin hatırlarımızı ve inançlarımızı şekillendirmede ne kadar güce sahip olması gerektiği konularında önemli soruları gündeme getiriyor.

Deepfake ile türetilen hatıraların tehlikesi

Deepfake’ler, insanların aslında hiç söylemediği şeyleri söylemiş veya yapmadığı şeyleri yapmış gibi gösteren ve gerçek gibi görünen videolar ve fotoğraflar oluşturmak için yapay zeka kullanır. Bu teknoloji, yapay sinir ağlarını yüksek miktardaki veriyle eğitmeyi içeren bir makine öğrenimi türü olan deep learning (derin öğrenme) üzerine kuruludur.

2019 yılında, internette 15 binden daha az deepfake bulunmuştu. Şu anda bu rakam milyonlara ulaşmış durumda. Dünya Ekonomik Forumu’na göre, uzmanlar tarafından oluşturulmuş deepfake sayısı yılda %900 oranında artmaya devam ediyor.

Deepfake’lerin en çok endişe verici taraflarından biri, sahte haberler ya da propaganda oluşturmak veya finansal kazanımlar için bir kişiyi taklit etmek gibi kötü amaçlar için kullanılma potansiyelidir. Bu teknoloji, ayrıca deepfake pornografi oluşturmak için de kullanılıyor ve bu durum da kişilerin istismar edilmesi ve suistimal için potansiyeli konusunda endişelere neden oldu.

Deepfake’ler, bu teknolojinin yüksek derecede gerçekçi yapısı nedeniyle, insanların gerçekte hiç olmayan şeyleri gördüklerine inanındırma gücüne de sahiptir. Bu da sonuç olarak, gerçek olmayan senaryoları gerçekmiş gibi hatırlamalarına neden olabilir.

Deepfake’lerin Mandela etkisine nasıl katkıda bulunabileceğine ve bunun sonucunda doğacak tehlikelere birkaç örneği derledik:

Sahte haberler oluşturma

Deepfake’ler, tamamen uydurma olmalarına rağmen insanların doğru olduğuna inandıracak derecede gerçekçi görünen sahte haberler oluşturmak için kullanılabilir. Örneğin, terörist saldırısı veya doğal afet gibi sahte haberler, geçmiş zamanlarda belirli sosyopolitik gündemleri sürükleme amacıyla ortaya atıldı. Bu hikayeler, deepfake’ler kullanılarak ikna edici video ve ses çekimleri ile oluşturulursa gerçek haber yayınlarıymış gibi görünmeleri sağlanabilir. Bu da nihayetinde jenerasyonlar boyunca tarihin ve olayların çarpıtılmış bir görüntüsünü oluşturabilir.

Politik görüşleri etkileme

2018’deki dönem ortası seçimlerinden birkaç ay önce, Barack Obama’nın o sıradaki başkan Donald Trump’ı kötü bir adla andığı bir deepfake videosu viral oldu. Bu video, Oscar ödüllü yönetmen Jordan Peele tarafından, internette karşılaştıkları verilere inanan kullanıcıları uyarma amacıyla oluşturuldu. İronik bir şekilde, birçok Trump destekçisinin videonun gerçek olduğunu sanmasıyla birlikte bu video ters tepti ve birçoğu sosyal medya üzerinden öfkelerini dile getirdi.

Bir politik adayın veya kamuya mal olmuş birinin aslında hiç olmamış bir şeyi söylediği veya yaptığı benzer bir video yeterince inandırıcı olursa, demokrasinin işleyişi ve insanların kurumlara olan inancı üzerinde zararlı etkileri olabilir.

Örneğin, ülkelerinin politik adaylarının sosyal medyada veya çeşitli haber kanallarında potansiyel olarak inandırıcı deepfake videosunu daha fazla kişi gördükçe, sahte hatıralar yayılabilir ve gerçekmiş gibi kabul edilebilir. Bu da insanların seçimlerde kullanacağı oyu ve liderleri olmalarını istedikleri insanları değiştirebilir.

Propaganda kampanyaları yürütme

Deepfake’ler ile oluşturulmuş propaganda kampanyaları, kamuoyunu yönlendirmek ve hükümet destekli gruplar hakkında yanlış bilgiler yaymak için kullanılabilir, sonuç olarak da gerçeğin çarpıtılmış bir görüntüsüne yol açabilir. Örneğin, Rusya ile devam eden çatışma nedeniyle, Ukrayna istihbaratı son zamanlarda Ukrayna Başkanı Volodymyr Zelenskyy’nin Ukraynalıları teslim olmaya çağırdığı görülen bir deepfake videosunun ortalıkta dolaştığı uyarısında bulundu.

Birçok platformun bu videoyu kaldırmasına rağmen, bu video Facebook, Reddit ve TikTok gibi birçok sosyal medya sitesinde ortaya çıkmaya devam ediyor, böylece halk arasında fikir ayrılığına neden oluyor ve gerçeği ayırt etmelerini daha da zorlaştırıyor.

Tarihsel görüntüleri değiştirme

Deepfake’ler, politik konuşma görüntüleri veya önemli olaylar gibi tarihsel görüntüleri, insanların aslında ne olduğu hakkındaki hatıralarını değiştirecek şekilde kullanılabilir. Bu, geçmişte aslında ne olduğu konusunda kafa karışıklığına ve belirsizliğe neden olabilir ve halkın tarihi kayıtlara ve medya olan güvenini yıpratabilir, bu da sonuç olarak komplo teorilerini besleyebilir.

Örneğin aya ayak basmayı ele alalım. Bazı insanlar günümüze kadar aya ayak basılmasının düzmece olduğuna ve aslında hiç gerçekleşmediğine inanıyor. Deepfake’ler, bu sahte öyküleri destekleyen inandırıcı video ve ses kayıtlarını üretmek için kullanılabilir ve tarihsel olayların gerçekliği üzerine kuşkuculuğu ve güvensizliği kuvvetlendirebilir.

Sosyal medya içeriklerini kötüye kullanma

Sosyal medya platformlarına erişim kolaylığıyla birlikte, deepfake’ler ünlülerin, kamuya mal olmuş kişilerin veya fenomenlerin, gerçekte yapmamalarına rağmen, bir etkinlikte yer aldıklarını veya belirli bir ürünün tanıtımını yaptıklarını gösteren sahte paylaşımlar oluşturmak için kullanılabilir. Deepfake’ler, yanlış hikayelerin kontrolsüz bir şekilde yayılmasına izin vererek toplumu daha çok kutuplaştırabilir ve dezenformasyon kampanyaları için üretken bir zemin oluşturabilir. Bu da dolayısıyla sosyal medyanın, demokrasi ve sosyal uyum için kritik olan, iletişim için bir araç olarak kullanılma güvenilirliğini zayıflatır.

Bilimsel kanıt uydurma

Deepfake’ler, bir virüsün çıkış noktasından tıbbi dönüm noktalarına kadar, gerçek olmayan iddiaları ve hipotezleri desteklemek için sahte bilimsel kanıt oluşturmak için kullanılabilir. Örneğin bazı insanlar, insan aktivitesinden kaynaklandığı konusunda kuvvetli bilimsel kanıtlara rağmen, iklim değişikliği hakkında yanlış bilgiler yaymaya çalışıyor. Bu, küresel ısınma gibi önemli konularda bir tehdit oluşturuyor.

Deepfake’ler, ciddi sonuçlar doğurabilecek şekilde, iklim değişikliğinin dış etkenlerden kaynaklandığını iddia eden sahte bilimsel kanıtlar oluşturabilir; bu da karar vericilerin, neden kaynaklandığı konusunda yaygın kuşkular bulunması durumunda iklim değişikliğinin üzerine gitmeyi hedefleyen eylemlerde bulunma olasılığını azaltır. Bu, kamuoyunu daha çok ayrıştırır ve bu acil sorunun üzerine nasıl gidileceği konusunda bir fikir birliğine varmayı daha da zorlaştırır.

Sahte gerekçeler oluşturma

Deepfake’ler ayrıca davalarda sahte itiraflar veya beyanlar oluşturmak ya da suçlular için gerekçe oluşturmak amacıyla güvenlik kamerası görüntülerini değiştirmek için kullanılabilir. Bu da suçun olayları etrafında oluşturulan sahte hikayelere yol açabilir ve insanlar a) sanığın suçu işlemediğine veya b) masum bir kişinin suç işlediğine inanabilir. Zamanla, bu sahte hikaye davaya dahil olan kişilerin kolektif hafızalarına gerçekmiş gibi yerleşebilir.

Savunma avukatlarının, sanığı suç saatinde farklı bir yerdeymiş gibi gösteren oldukça gerçekçi bir deepfake video oluşturduğu bir sansasyonel dava olduğunu varsayalım. Bu video yaygın bir şekilde dolaşıyor ve insanlar sanığın bu cinayeti gerçekleştiremeyeceğine inanıyor. Videonun daha sonra bir deepfake olduğu kanıtlansa ve sanık suçlu bulunsa bile, bazı insanlar videoyla ilgili hatıraları nedeniyle sanığın masum olduğuna inanmaya devam edebilir.

Bir deepfake’i ayırt etmenin 10 yöntemi

Abraham Lincoln’ün deyişiyle: “İnternette gördüğünüz hiçbir şeye inanmayın.” Sahte hatıralar oluşturan deepfake sorunuyla mücadele için, hepimizin tükettiğimiz bilgiler konusunda titiz ve şüpheci olmaya devam etmemizin yanı sıra, teknoloji şirketlerinin ve hükümetlerin birlikte çalışarak deepfake videolarını algılayacak ve yayılmalarını önleyecek çözümler geliştirmek amacıyla birlikte çalışmaları gerekiyor.

Bu süre içerisinde, kendinizi dezenformasyona ve sahte hatıralara karşı korumak için deepfake’leri nasıl ayırt edebileceğinizi öğrenin:

- Yüzlerde biçim bozulmaları ve değişimler

- Yüzde ışık ve 3 boyutlu değişim bozuklukları arayın

- Yanaklar, alın, kaşlar ve yüzdeki kıllar başta olmak üzere, dokudaki tutarsızlıkları kontrol edin

- Gerçekçi göz ve dudak hareketleri

- Gölgeleme, göz rengi ve yüzdeki lekelerin ve göz kırpmanın gerçekçi görünüp görünmediğini kontrol edin

- Görüntüdeki öznenin dudaklarının doğal ve o yüze ait olduğunu doğrulayın

- Öznenin hareketleri ve mimikleri

- Videodaki öznenin hareketlerine ve mimiklerine dikkat edin

- Çok garip ve haddinden fazla kusursuz görünüp görünmediklerini kontrol edin

- Ses analizi

- Videodaki sesi dikkatli bir şekilde dinleyin

- Yapay zeka kullanarak oluşturulmuş veya değiştirilmiş sesler kullanıyor olabileceğinden, sesin kulağa yapay gelip gelmediğini veya bozukluğa sahip olup olmadığını kontrol edin

5.Işıkta ve yansımalarda tutarsızlık

- Işıkta ve yansımalarda, ortamla eşleşmeyen veya videodaki ya da görüntüdeki kişinin pozisyonu ile eşleşmeyen tutarsızlıklar arayın

- Videonun içeriğini soruşturun

- İçeriğini soruşturmak için orijinal videoyu bulun veya diğer örnekleri için bir arama gerçekleştirin

- Google Görseller, TinEye, SauceNAO veya Bing Görsel Arama gibi araçları kullanarak tersten görüntü aramayı kullanın

- İçeriksel analiz

- Gerçek olup olmadığını gösterebileceğinden dolayı, videonun yayınlandığı veya paylaşıldığı içeriği değerlendirin (örneğin, papa neden genellikle giydiği kendine özgü kıyafetleri aniden değiştirir?)

- İster bir saygın haber ajansı, ister sosyal medyada rastgele veya tartışmalı bir gündeme sahip bir kişi olsun, videonun orijinal kaynağını kontrol edin

- Doğal veya yaygın olmayan durumlar

- Karakterine aykırı bir şey yapan ünlü biri veya tartışmalı bir ifadede bulunan bir politikacı gibi, yaygın veya olası olmayan durumları gösteren videolara kuşkuyla yaklaşın

- Üstverileri kontrol edin

- Videoda iddia edilenlerle eşleşip eşleşmediğini görmek için videonun kayıt saati ve yeri gibi üstverilerini kontrol edin

- Üstverilerin çok kolay bir şekilde değiştirilebileceğini aklınızda tutun, bu nedenle üstveriler bir videonun gerçekliğini belirlemek için tek dayanak olmamalıdır

- Güncel kalın

- Deepfake’leri oluşturmak için kullanılan teknolojinin sürekli geliştiğini ve gelecekte onları ayırt etmenin giderek zorlaşabileceğini unutmayın

- Bu alandaki yenilikleri mümkün olduğunca takip ettiğinizden emin olun ve şüpheli veya haber değeri çok yüksek videoları paylaşırken veya onlara reaksiyon gösterirken temkinli olun

İnternette korunmak için ilk adımı at. ExpressVPN’i risksiz dene.

ExpressVPN’i edin